· Meta的Zuckerberg(扎克伯格):“在基础设施上超支数千亿美元的风险,小于被排除在外的风险。”

· 知名半导体机构Semianalysis 的Dylan Patel透露:“OpenAI和Anthropic目前占据Nvidia GPU总出货量三分之一的份额,成为最大终端买家。”

· 《The NVIDIA Way》一书作者Tae Kim在公开媒体发文指出:“问世8年的TPU利用率仍达100%,5年前发布的A100 GPU也已经售罄。”

· Groq CEO、Google TPU创始人之一Jonathan Ross表示:“在Groq采用1年期摊销,那些沿用3-5年摊销期的做法“完全错了”。芯片不仅涉及资本支出(CapEx)的前期投资,还包括运营支出(OpEx)以及电力、水冷等配套成本。”

……

当前全球科技与算力大厂都在疯狂卷AI与算力,以上言论值得关注,智算中心运营正面临一个巨大的隐藏风险:智算中心GPU的资本支出与折旧问题。

当前主流芯片更新周期

下面是结合当前市场情况,列出的一些国内外主流芯片的更新周期(仅供参考):

但实际运营智算中心时,面临的问题要比上表呈现出来的数字复杂得多。

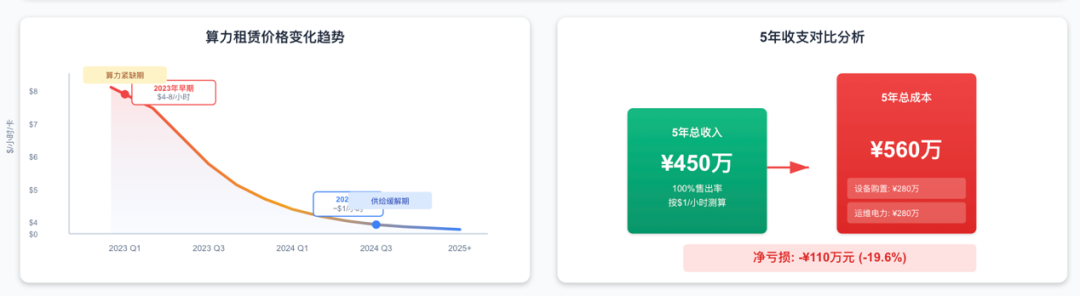

举个例子,以AI算力云业务的GPU投资回报周期为例:一台搭载8×NVIDIA H100 GPU服务器(成本假设为¥280万元人民币),在2023年前期算力紧缺时其租用价格一度高达每卡每小时4~8美元,若保持高利用率,十多个月即可收回成本。这使得不少运营者初期ROI(投资回报)看起来非常可观。然而随着2024年供给缓解、算力租赁价格下滑,中期租价降至每卡仅1美元/小时左右,按100%售出率测算5年总收入约¥450万,扣除设备与机房等成本(约¥560万,含服务器购置和5年运维电力等附加成本,五年反而亏损约¥110万。直线折旧法下前两年盈利、第三年开始亏损的现象表明:GPU资产的经济寿命通常小于账面折旧年限。

为弥补后期亏损,常见做法是在第3年时再投入更新一批更新一代GPU,用新设备盈利来填补旧设备的折旧亏损,进行滚动扩张,但这也潜藏风险(扩大杠杆可能隐藏亏损直至难以为继)。因此,运营方更倾向于在性能/效率显著提升的新品出现时尽早更新GPU,保证算力供给具备竞争力,并避免旧卡后期大幅贬值带来的亏损,但这样又会带来新的风险。

GPU的折旧速度比想象的要快

当前一代 GPU 的使用寿命比大多数人认为的要短,也比公司在摊销计划中预估的要短。我们正进入AI周期的下一阶段,在这个阶段,数据中心和能源供应日趋紧张,最重要的指标已经变成每瓦特产出的Token数 (tokens per watt)。需要关注的是,像Nvidia这样的芯片厂商已经转向1年的产品升级周期,这意味着每年你都能获得比上一代更强大、更节能的加速器。这与我们历史上经历的摩尔定律和芯片发展完全不同。Jensen (黄仁勋) 指出,从Hopper到Blackwell,将Token成本降低了10倍。也就是说随时未来的发展,GPU的摊销速度应该比新兴云服务商和超大规模云服务商建模的速度要快得多。在最近一期播客中,Groq的CEO Jonathan Ross,Google TPU 创始人之一就表示,Groq正采用1年期的摊销(那些采用 3-5 年摊销期的人完全错了)。对于芯片,你不仅有资本支出的前期投资,还有运行该芯片的运营支出 (OpEx),以及相关的电力和水冷成本。超大规模云服务商对GPU采用3-4年的摊销周期,而Corewave和一些新兴云服务商采用6年的Nvidia GPU折旧周期,但问题来了,如果他们的摊销周期是2年而不是6年,这些新兴云服务商的亏损会大得多,这是整个产业链中一个令人担忧的一个重要压力点。

智算中心运营的最大风险

可能有人会说,我看到很多人在租用Nvidia H100,那是Nvidia 3年前开始销售的产品,但这背后其实有两个重要原因。

第一,少量大客户(比如类似OpenAI和Anthropic)将需求推得极高,因为他们向最终用户提供服务的算力成本远高于他们向最终用户收取的价格,但这种模式只有在投资者愿意持续提供资金的阶段才能维持。

第二,更重要一点——H100已经有3年历史依然有用,因为Nvidia是在 H100和Blackwell之间才转向1年产品周期的,而这个转变发生在2024 年末。在此之前,周期是18-24个月。所以,产品代数角度来看,相比用年份衡量,这款芯片并不算太老。然而,随着 Nvidia现在采用1年产品周期,情况发生了重大变化,如此推算这些芯片的真实摊销期应该是1-2年。

回到以6年摊销计算的Coreweave。这意味着,当Nvidia Vera Rubin在2026年末正式推出时,AI推理需求已经大幅提升,智算中心需要持续运行GPU需要持续高负荷运行时,必须要建造新数据中心才能维持,但这需要时间。所以,带来的结果就是,对于想要扩展算力大部分公司将不得不在现有运行的数据中心中用新GPU替换旧GPU,以获得更多每瓦特Token产出,因为他们的功耗受到限制,这将会在实际上大幅压缩GPU芯片资产的摊销周期。

所以,当下延长GPU摊销周期的问题在于,即使今天利润看起来比实际更高,但当GPU换代的真实动作发生时就会面临成本大增亏损的风险。这也就解释了微软这类企业为什么会选择和云服务商合作:因为围绕看到客户对算力的需求激增。Microsoft希望维护客户关系并让客户满意,但对进一步增加资本支出缺乏足够信心,所以宁愿将部分风险转移给其他方。客户不知道也不在乎Microsoft是否拥有物理基础设施,当热潮消退时,Microsoft不必将芯片计为损失,因为新兴云服务商已经承担了这一风险。这对Microsoft而言是双赢——他们保留了客户,如果需求被证实是长期可持续的,他们有充足时间建设自己的数据中心并转回自身基础设施。与此同时,在当前所处的狂热周期中,微软还可以将芯片过时速度超预期的风险转移出去。总之,GPU作为AI时代数据中心的核心资产,其折旧和评估需要动态权衡技术演进和经济回报。对于高端GPU,3年前后即进入更新窗口,高负载环境甚至更短;数据中心整体资产评估则融合了财务折旧和算力价值视角,既看设备账面生命周期,也看其在不断变化的AI市场中的供需价值。不同区域由于运营环境和策略差异,在设备折旧和资产管理上各有侧重:比如我国重要强调可控回报和国产替代,北美追求效率领先和灵活财务,东南亚注重成本管控和外部支持。在未来几年,随着AI芯片技术的发展和各地算力需求的成熟,GPU资产的折旧策略和评估方法也将持续变化,值得算力产业高度关注。